数字化浪潮中,企业每天沉淀海量数据,却常因字段错乱、格式混乱、信息缺失而难以支撑精准决策。是不是每次开会,面对一堆杂乱报表都无从下手?本文将以6大核心步骤,带你系统化梳理数据清洗全流程,让“脏数据”焕发生机。

一、明确业务场景与数据质量评估

• 定义目标:先问自己,“这份数据要回答什么问题?能产生哪些价值?”

• 核心指标:

二、数据探查与诊断

• 分布检测:查看数值型字段的最小值、最大值、均值、标准差

• 缺失统计:识别高缺失字段,评估保留或剔除

• 格式校验:用正则或脚本检查日期、邮箱、手机号等特殊格式

• 逻辑校验:例如年龄与出生日期比对,发现潜在矛盾。

例如,一家零售平台通过探查,发现“月度活跃用户”漏记率高达15%,正是优化重点。

三、数据清洗核心六步

1. 去重(Deduplication) – 按主键、邮箱或姓名+电话多维组合查重 – 保留最新或最完整记录,其余剔除

2. 缺失值处理 – 删除法:当缺失率>80%时,可直接剔除字段 – 填充法:数值字段补均值、中位数;分类字段补众数或“未知” – 插补法:基于相似样本或机器学习模型预测填充

3. 异常值检测 – 分位数法、Z-score、箱型图定位离群值 – 对输入错误可修正,如“20201301”→“20210130”;对极端离群赋予标记或剔除

4. 格式标准化 – 统一日期格式为YYYY-MM-DD – 统一计量单位,如把分、元统一为元 – 字符串去除多余空格、统一大小写

5. 字段映射与校验 – 根据数据字典将字段名和值域映射到标准 – 通过省市区三级联动等业务规则再次校验

6. 完整性与一致性复检 – 再次运行探查脚本,确认各项指标达标 – 输出清洗报告,为审计与回溯留痕

四、常见数据错误类型全景

– 重复记录:系统同步不当、导入多次

– 缺失值:手工录入遗漏、接口超时

– 格式错误:日期、编码、货币符号混乱

– 文本噪声:特殊字符、HTML标签

– 逻辑冲突:年龄与出生日期不符、交易时间错置

五、案例解析:某零售企业数据清洗实践

在一次促销复盘中,该企业对100万条订单数据执行上述流程,仅用两周时间:

• 缺失值率从12%降至3%

• 异常订单剔除率达1.8%

• 报表生成效率提升60%

清洗后的数据为营销模型提供了更真实的样本,精准推荐点击率提升2倍。

六、数据治理框架搭建

7. 组织与角色:由CDO统筹,工程师、分析师、QA协同

8. 标准与流程:制定数据字典、命名规范、质量检验规则

9. 技术与工具:ETL平台(Apache NiFi、Informatica)、脚本化工具(Python、SQL)

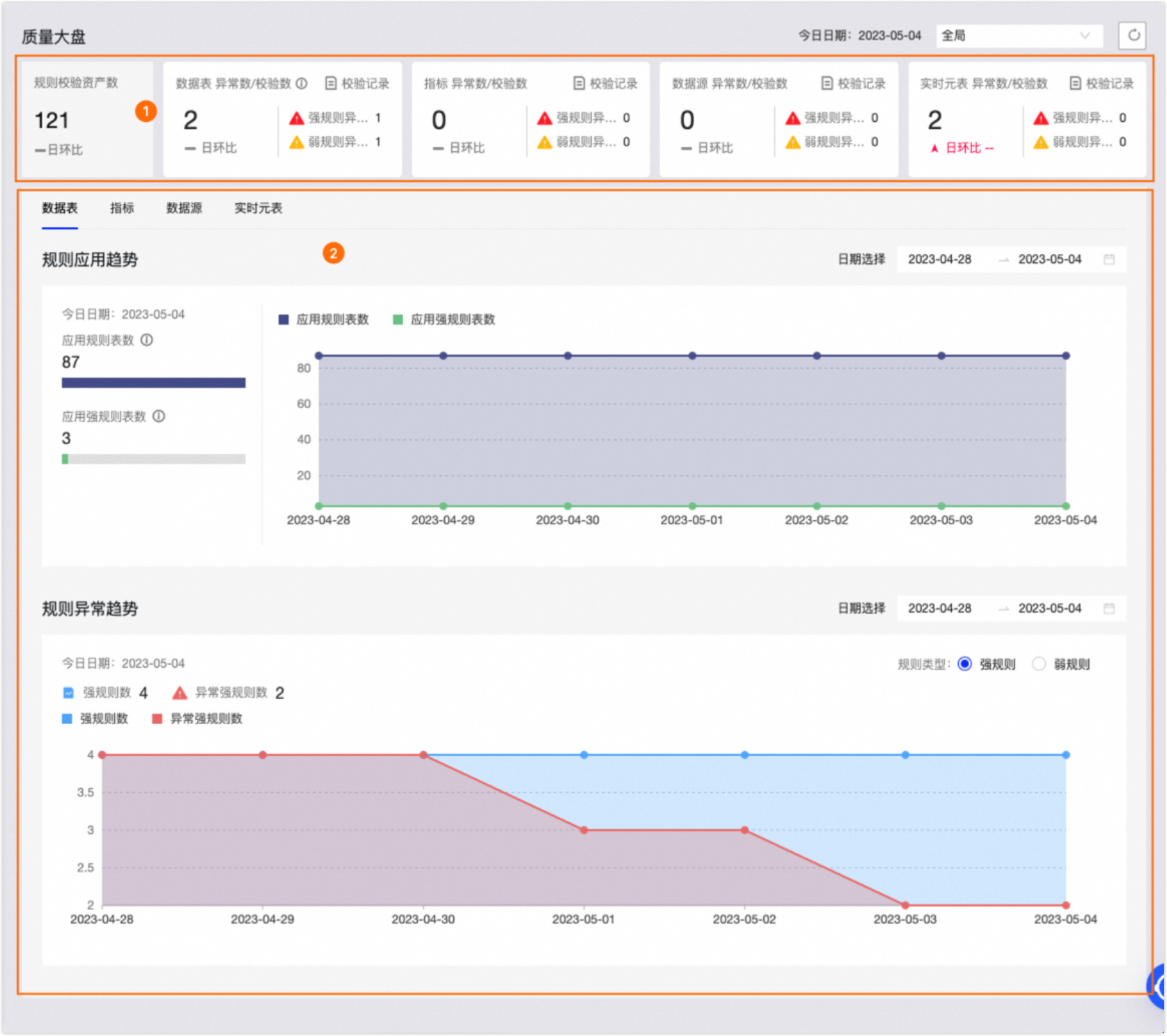

10. 监控闭环:实时质量看板、告警、规则迭代

七、清洗后价值多维体现

• 决策更精准:支撑BI仪表盘,洞察深层趋势

• 效率显著提升:重复劳动减少,团队聚焦模型与创新

• 风险规避:定价、订单处理、合规审查风险降低

• 下游放大:模型准确度提高,转化率和ROI双双跃升

系统化的数据清洗与治理,可让“脏数据”重获价值,真正驱动企业增长。如果你的项目中也遇到清洗难题,欢迎在评论区交流心得;觉得本文实用,别忘点赞、收藏,并关注我们,获取更多数据治理干货!